Superdatorer

Som superdatorer (inklusive högpresterande dator eller superdator kallas) är särskilt snabba för sin tid som datorn kallas. Det är irrelevant vilken typ av konstruktion datorn bygger på, så länge det är en universellt användbar dator. En typisk egenskap hos en modern superdator är dess särskilt stora antal processorer som kan komma åt delade kringutrustning och ett delvis delat huvudminne . Superdatorer används ofta för datasimuleringar inom högpresterande datorer .

Superdatorer spelar en viktig roll i vetenskaplig beräkning och används inom olika discipliner, såsom simuleringar inom kvantmekanik , väderprognoser , klimatologi , upptäckt av olje- och gasavlagringar, molekylär dynamik, biologiska makromolekyler, kosmologi , astrofysik , fusionsforskning , forskning om kärnvapentester för kryptoanalys .

I Tyskland finns superdatorer främst vid universitet och forskningsinstitutioner som Max Planck -instituten . På grund av deras möjliga användning omfattas de av tyska lagar om vapenexportkontroll .

Historia och struktur

I datorutvecklingens historia separerade superdatorer från vetenskapliga datorer och stordatorer på 1960 -talet . Medan stordatorer var optimerade för hög tillförlitlighet, var superdatorer optimerade för hög datorkraft. Den första officiellt installerade superdatorn Cray-1 klarade 130 MegaFLOPS 1976 .

Ursprungligen uppnåddes enastående datorkraft genom att maximalt utnyttja tillgänglig teknik genom att välja konstruktioner som var för dyra för större serieproduktion (t.ex. vätskekylning, exotiska komponenter och material, kompakt design för korta signalvägar); antalet processorer var ganska högre liten mängd. Sedan en tid tillbaka har så kallade kluster etablerat sig där ett stort antal (oftast billiga) enskilda datorer är nätverksanslutna för att bilda en stor dator. Jämfört med en vektordator har noder i ett kluster sina egna kringutrustning och endast sitt eget lokala huvudminne . Kluster använder standardkomponenter, varför de initialt erbjuder kostnadsfördelar jämfört med vektordatorer. De kräver dock mycket mer programmeringsinsats. Det måste övervägas om de program som används är lämpliga för att distribueras över många processorer.

Moderna högpresterande datorer är främst parallella datorer . De består av ett stort antal datorer i nätverk med varandra. Dessutom har varje dator vanligtvis flera huvudprocessorer (CPU: er). Samma program kan inte köras omodifierade på en superdator som på en vanlig dator, utan snarare särskilt samordnade program som håller de enskilda processorerna parallella. Superdatorer (som alla kommersiellt tillgängliga datorer i lägre prissegment idag) är vektordatorer. Standardarkitekturer från persondatorer och servrar , till exempel x86-64 från Intel (Xeon) och AMD (Epyc), är nu dominerande . De skiljer sig bara något från vanlig datorhårdvara. Men det finns fortfarande speciell hårdvara som IBM BlueGene / Q och Sparc64.

I superdatorer implementeras anslutningarna mellan enskilda datorer med hjälp av speciella högpresterande nätverk; InfiniBand är bland annat utbrett . Datorer är ofta utrustade med acceleratorkort, till exempel grafikkort eller Intel Xeon Phi . Grafikkort är lämpliga för användning i högpresterande datorer eftersom de representerar utmärkta vektoritmetiska enheter och effektivt löser linjära algebraproblem . Den tillhörande tekniken kallas General Purpose Computation on Graphics Processing Unit (GPGPU).

För kluster är de enskilda datorerna ofta noder (engelska noder ) som anropas och centralt konfigureras av Clustermanagament -verktyg och övervakas.

Operativsystem och programmering

Medan olika Unix -varianter fortfarande var utbredda i superdatorer på 1990 -talet, etablerade gratisprogramvaran Linux sig som operativsystem på 2000 -talet . Den TOP500 lista över de snabbast datorsystem (i juni 2012) listar totalt 462 system som drivs uteslutande under Linux och 11 delvis (CNK / SLES 9) system drivs under Linux. Detta innebär att 92,4% av systemen körs helt under Linux. Nästan alla andra system drivs under Unix eller Unix-liknande system. Den största konkurrenten på skrivbordsområdet, Windows , spelar knappast någon roll i det högpresterande datorområdet (0,4%).

Programmeringsspråken som används för programmeringsprogram är främst Fortran och C eller C ++ . För att generera kod så snabbt som möjligt används vanligtvis kompilatorer från superdatorstillverkare (t.ex. CRAY eller Intel). HPC -program (High Performance Computing) är vanligtvis indelade i två kategorier:

- Delad minnesparallellisering , vanligtvis lokalt på en enda nod. Gränssnitt som OpenMP eller TBB är vanliga för detta ändamål . En enda operativsystemsprocess använder vanligtvis alla tillgängliga CPU -kärnor eller processorer.

- Distribuerad minnesparallalisering: En operativsystemprocess körs på en kärna och måste utbyta meddelanden med andra processer för gemensam problemlösning ( meddelandeöverföring ). Detta går inom noden eller över nodgränserna. Den MPI är defact standard för programmering denna typ av program.

I praktiken hittar man ofta en kombination av båda parallelliseringsteknikerna, som ofta kallas hybridparallellisering . Det är populärt eftersom program ofta inte är tillräckligt bra för att kunna använda alla kärnor i en superdator med rena meddelandeöverföringar .

Om superdatorer är utrustade med acceleratorkort (grafikkort eller aritmetiska kort) bryts programmeringen ner igen i värddatorn och acceleratorkortets. OpenCL och CUDA är två gränssnitt som möjliggör programmering av sådana komponenter.

Som regel används högpresterande datorer inte av en enda användare eller ett program. Istället används jobbschemaläggare som Simple Linux Utility for Resource Management (SLURM) eller IBMs LoadLeveler för att tillåta ett stort antal användare att använda delar av superdatorn under en kort tid. Tilldelningen sker uteslutande på nivån för nodallokering eller processorallokering. Den processortid som används mäts i enheter såsom CPU-timmar eller nod timmar och faktureras vid behov.

Avsedd användning

Produktionskostnaderna för en superdator från TOP10 ligger för närvarande på det höga tvåsiffriga, ofta redan tresiffriga miljonbeloppet.

Dagens superdatorer används främst för simuleringsändamål . Ju mer realistisk en simulering av komplexa relationer blir, desto mer datorkraft krävs vanligtvis. En fördel med superdatorer är att de kan ta hänsyn till fler och fler beroende beroende på deras extremt snabba och därför stora datorkraft . Detta gör det möjligt att inkludera mer långtgående, ofta oansenliga sekundära eller gränsvillkor för den faktiska simuleringen och garanterar därmed ett allt mer meningsfullt helhetsresultat.

De nuvarande huvudsakliga tillämpningsområdena för superdatorer som erbjuds inkluderar biologi , kemi , geologi , flyg och rymd , medicin , väder , klimatforskning , militär och fysik .

På det militära området har superdatorer t.ex. B. möjliggör nya atombombutvecklingar genom simulering, utan att stödja data genom ytterligare underjordiska atombombtest. Områdena kännetecknas av att de är mycket komplexa system eller delsystem som i stor utsträckning är kopplade till varandra. Förändringar i ett delsystem har vanligtvis mer eller mindre starka effekter på närliggande eller anslutna system. Användningen av superdatorer gör det allt enklare att ta hänsyn till många sådana konsekvenser eller till och med att förutsäga dem, vilket gör att eventuella motåtgärder kan vidtas i god tid. Detta gäller t.ex. B. i simuleringar av klimatförändringar , förutsägelser av jordbävningar eller vulkanutbrott samt inom medicin med simulering av nya aktiva ämnen på organismen . Sådana simuleringar är logiskt, helt oberoende av datorkraften, bara så exakta som de programmerade parametrarna eller modellerna tillåter beräkningen. De enorma summor pengar som investeras i den ständiga ökningen av FLOPS och därmed utvecklingen av allt snabbare superdatorer motiveras främst av fördelarna och den möjliga ”kunskapsfördelen” för mänskligheten, mindre av aspekterna av allmän teknisk utveckling.

Läget i Tyskland

Vetenskaplig högpresterande datorer organiseras i Tyskland av Gauss Center for Supercomputing (GCS), som är medlem i European Partnership for Advanced Computing in Europe (PRACE). Majoriteten av de 16 tyska förbundsstaterna upprätthåller statliga högdatorföreningar för att organisera användningen av sina högpresterande datorer. I den vetenskapliga världen annonseras och fördelas vanligtvis en kvot med CPU -timmar mellan sökande.

Utvalda superdatorer

Nuvarande superdatorer

De snabbaste superdatorer när det gäller prestanda listas nu var sjätte månad i TOP500 -listan. LINPACK -riktmärket fungerar som grund för utvärdering. De snabbaste superdatorer enligt energieffektivitet eller MFLOPS / W har funnits på Green500 -listan sedan november 2007. Lenovo installerade den största andelen (117) av de 500 mest kraftfulla datorerna världen över 2018 .

Denna Green500-lista från november 2014 visar genomsnittlig effektivitet per land på land på 1895 MFLOPS / W (Italien) ner till 168 MFLOPS / W (Malaysia).

Utvalda nuvarande superdatorer (över hela världen)

Från och med juni 2017 (2016?). Men Piz Daint, Schweiz tillade.

| Efternamn | Plats | Tera FLOPS | konfiguration | Energikrav | ändamål |

|---|---|---|---|---|---|

| Fugaku | RIKEN Center for Computational Science , Kobe , ( Japan ) | 415 530,00 | 152.064 A64FX (48 kärnor, 2,2 GHz), 4,64 PB RAM | 15 000 kW | Vetenskapliga tillämpningar |

| Topp | Oak Ridge National Laboratory ( Tennessee , USA ) | 122 300,00 uppgraderat till 148 600,00 | 9166 POWER9 -processorer (22 kärnor, 3,1 GHz), 27648 Nvidia Tesla V100 GPU: er | 10.096 kW | Fysiska beräkningar |

| Sunway TaihuLight | National Supercomputing Center, Wuxi , Jiangsu | 93 014,60 | 40 960 Sunway SW26010 (260 kärnor, 1,45 GHz), 1,31 PB RAM, 40 serverhyllor med 4 × 256 noder vardera, totalt 10 649 600 kärnor | 15 370 kW | Vetenskapliga och kommersiella tillämpningar |

| Sierra | Lawrence Livermore National Laboratory ( Kalifornien , USA) | 71 600,00 | IBM Power9 (22 kärnor, 3,1 GHz) 1,5 PB RAM | 7438 kW | fysiska beräkningar (t.ex. simulering av kärnvapentester) |

| Tianhe-2 | National University for Defense Technology, Changsha , Kina slutlig plats: National Supercomputer Center ( Guangzhou , Folkrepubliken Kina ) |

33 862,70 uppgraderat till 61 400,00 | 32 000 Intel Xeon E5-2692-processorer (Ivy Bridge, 12 kärnor, 2,2 GHz) + 48 000 Intel Xeon Phi 31S1P -samprocessorer (57 kärnor, 1,1 GHz), 1,4 PB RAM | 17 808 kW | Kemiska och fysiska beräkningar (t.ex. studier av petroleum- och flygplanets utveckling) |

| Hök | High Performance Computing Center Stuttgart ( Tyskland ) | 26 000,00 | 11 264 AMD EPYC 7742 (64 kärnor, 2,25 GHz), 1,44 PB RAM | 3500 kW | Vetenskapliga och kommersiella tillämpningar |

| Piz Daint | Swiss National Supercomputing Center (CSCS) ( Schweiz ) | 21 230,00 | Cray XC50, Xeon E5-2690v3 12C 2,6 GHz, Aries interconnect, NVIDIA Tesla P100, Cray Inc. (361760 kärnor) | 2 384 kW | vetenskapliga och kommersiella tillämpningar |

| titan | Oak Ridge National Laboratory ( Tennessee , USA ) | 17 590,00 | Cray XK7, 18688 AMD Opteron 6274 -processorer (16 kärnor, 2,20 GHz) + 18688 Nvidia Tesla K20 GPGPU: er, 693,5 TB RAM | 8 209 kW | Fysiska beräkningar |

| Sequoia | Lawrence Livermore National Laboratory ( Kalifornien , USA ) | 17 173,20 | IBM BlueGene / Q, 98304 Power BQC -processorer (16 kärnor, 1,60 GHz), 1,6 PB RAM | 7 890 kW | Simulering av kärnvapentester |

| K dator | Advanced Institute for Computational Science ( Japan ) | 10 510,00 | 88128 SPARC64 -VIII 8 -kärniga processorer (2,00 GHz), 1377 TB RAM | 12 660 kW | Kemiska och fysikaliska beräkningar |

| Mira | Argonne National Laboratory ( Illinois , USA ) | 8586,6 | IBM BlueGene / Q, 49152 Power BQC -processorer (16 kärnor, 1,60 GHz) | 3.945 kW | Utveckling av nya energikällor, teknik och material, bioinformatik |

| JUQUEEN | Research Center Jülich ( Tyskland ) | 5,008,9 | IBM BlueGene / Q, 28672 Power BQC -processorer (16 kärnor, 1,60 GHz), 448 TB RAM | 2.301 kW | Materialvetenskap, teoretisk kemi, elementär partikelfysik, miljö, astrofysik |

| Fas 1 - Cray XC30 | European Center for Medium Range Weather Forecasts ( Reading , England ) | 3,593,00 | 7.010 Intel E5-2697v2 "Ivy Bridge" (12 kärnor, 2,7 GHz) | ||

| SuperMUC IBM | Leibniz Computing Center (LRZ) ( Garching nära München , Tyskland ) | 2897,00 | 18.432 Xeon E5-2680-processorer (8 kärnor, 2,7 GHz) + 820 Xeon E7-4870-processorer (10 kärnor, 2,4 GHz), 340 TB RAM | 3.423 kW | Kosmologi om universums bildande, seismologi / jordbävningsprognos och mycket mer. |

| Panik | Texas Advanced Computing Center ( Texas , USA ) | 5 168,10 | Xeon E5-2680 processorer (8 kärnor, 2,7 GHz) + Xeon E7-4870 processorer, 185 TB RAM | 4 510 kW | Kemisk och fysisk, biologisk (t.ex. analys av proteinstruktur), geologisk (t.ex. jordbävningsprognos), medicinska beräkningar (t.ex. cancertillväxt) |

| Tianhe-1A | National Supercomputer Center ( Tianjin , Folkrepubliken Kina ) | 2 266,00 | 14,336 Intel 6-kärniga Xeon X5670-processorer (2,93 GHz) + 7,168 Nvidia Tesla M2050 GPGPU: er , 224 TB RAM | 4 040 kW | Kemiska och fysiska beräkningar (t.ex. studier av petroleum- och flygplanets utveckling) |

| Morgondagens nebulosor | National Supercomputing Center ( Shenzhen , Kina ) | 1 271,00 | Hybridsystem med 55 680 Intel Xeon -processorer (2,66 GHz) + 64 960 Nvidia Tesla GPGPU (1,15 GHz), 224 TB RAM | 2580 kW | Meteorologi, finans och andra |

| IBM Roadrunner | Los Alamos National Laboratory ( New Mexico , USA ) | 1 105,00 | 6000 AMD dubbelkärniga processorer (3,2 GHz), 13 000 IBM Cell- processorer (1,8 GHz), 103 TB RAM | 4 040 kW | Fysiska simuleringar (t.ex. kärnvapensimuleringar) |

| N. n. | Bielefeld University ( Tyskland ) | 529,70 | 208x Nvidia Tesla M2075-GPGPU: er + 192x Nvidia GTX-580-GPU: er + 152x dubbla fyrkärniga Intel Xeon 5600-processorer, 9,1 TB RAM | Fysiska fakulteten: Numeriska simuleringar, fysiska beräkningar | |

| SGI Altix | NASA ( USA ) | 487,00 | 51 200 4-kärniga Xeon, 3 GHz, 274,5 TB RAM | 3897 kW | Utforskning av rymden |

| BlueGene / L. | Lawrence Livermore National Laboratory Livermore ( USA ) | 478,20 | 212 992 PowerPC 440 -processorer 700 MHz, 73 728 GB RAM | 924 kW | Fysiska simuleringar |

| Blue Gene Watson | IBM Thomas J. Watson Research Center ( USA ) | 91,29 | 40 960 PowerPC 440 -processorer, 10 240 GB RAM | 448 kW | Forskningsavdelning för IBM, men även applikationer från vetenskap och ekonomi |

| ASC Lila | Lawrence Livermore National Laboratory Livermore ( USA ) | 75,76 | 12 208 Power5 -processorer, 48 832 GB RAM | 7500 kW | Fysiska simuleringar (t.ex. kärnvapensimuleringar) |

| MareNostrum | Universitat Politècnica de Catalunya ( Spanien ) | 63,8 | 10 240 PowerPC 970MP 2,3 GHz, 20,4 TB RAM | 1 015 kW | Klimat- och genetisk forskning, apotek |

| Columbia | NASA Ames Research Center ( Silicon Valley , Kalifornien , USA ) | 51,87 | 10.160 Intel Itanium 2 -processorer (Madison -kärna), 9 TB RAM | Klimatmodellering, astrofysiska simuleringar |

Utvalda nuvarande superdatorer (i hela Tyskland)

| Efternamn | Plats | Tera FLOPS (topp) | konfiguration | TB RAM | Energikrav | ändamål |

|---|---|---|---|---|---|---|

| Hök | High Performance Computing Center Stuttgart ( Tyskland ) | 26 000,00 | 11 264 AMD EPYC 7742 (64 kärnor, 2,25 GHz), 1,44 PB RAM | 1440 | 3500 kW | Vetenskapliga och kommersiella tillämpningar |

| SMYCKER | forskningscentrum Julich | 9 891,07 | 2511 noder med 4 dubbla Intel Xeon Platinum 8168 vardera (med 24 kärnor vardera, 2,70 GHz), 64 noder med 6 dubbla Intel Xeon Gold 6148 vardera (med 20 kärnor vardera, 2,40 GHz) | 258 | 1361 kW | |

| JUQUEEN | Research Center Jülich ( Tyskland ) | 5 900,00 | IBM BlueGene / Q, 28672 Power BQC -processorer (16 kärnor, 1,60 GHz) | 448 | 2.301 kW | Materialvetenskap, teoretisk kemi, elementär partikelfysik, miljö, astrofysik |

| SuperMUC IBM | Leibniz Computing Center (LRZ) ( Garching nära München , Tyskland ) | 2897,00 | 18 432 Xeon E5-2680-processorer (8 kärnor, 2,7 GHz), 820 Xeon E7-4870-processorer (10 kärnor, 2,4 GHz) | 340 | 3.423 kW | Kosmologi om universums bildande, seismologi och förutsägelser av jordbävningar |

| HLRN-III (Cray XC40) | Zuse Institute Berlin , regionalt datacenter för Niedersachsen | 2 685,60 | 42 624 kärnor Intel Xeon Haswell @ 2,5 GHz och IvyBridge @ 2,4 GHz | 222 | 500 - 1.000 kW | Fysik, kemi, miljö- och marin forskning, teknik |

| HRSK-II | Center for Information Services and High Performance Computing , TU Dresden | 1 600,00 | 43 866 CPU -kärnor, Intel Haswell EP -processorer (Xeon E5 2680v3), 216 Nvidia Tesla -GPU: er | 130 | Vetenskapliga tillämpningar | |

| HLRE-3 "Mistral" | German Climate Computing Center Hamburg | 1 400,00 | 1550 noder med 2 Intel Haswell EP-processorer (Xeon E5-2680v3) (12 kärnor 2,5 GHz), 1750 noder med 2 Intel Broadwell EP-processorer (Xeon E5-2695V4) (18 kärnor 2,1 GHz), 100 000 kärnor, 54 PB Luster-hårddisk system, 21 visualiseringsnoder (á 2 Nvidia Tesla K80 GPU) eller (á 2 Nvidia GeForce GTX 9xx) | 120 | Klimatmodellering | |

| Cray XC40 | Tyska väderservice (Offenbach) | 1 100,00 | Cray Aries Network; 1952 processorer Intel Xeon E5-2680v3 / E5-2695v4 | 122 | 407 kW | Numerisk väderprognos och klimatsimuleringar |

| Lichtenberg högpresterande dator | Darmstadt tekniska universitet | 951,34 | Fas 1: 704 noder med 2 Intel Xeon (8 kärnor), 4 noder med 8 Intel Xeon (8 kärnor), 70 noder med 2 Intel Xeon.

Fas 2: 596 noder med 2 Intel Xeon (12 kärnor), 4 noder med 4 Intel Xeon (15 kärnor), 32 noder med 2 Intel Xeon. |

76 | Vetenskapliga tillämpningar | |

| CARL och EDDY | Carl von Ossietzky universitet i Oldenburg | 457,2 | Lenovo NeXtScale nx360M5, 12 960 kärnor (Intel Xeon E5-2650v4 12C 2,2 GHz), Infiniband FDR | 80 | 180 kW | Teoretisk kemi, vindenergiforskning, teoretisk fysik, neurovetenskap och hörselforskning, marin forskning, biologisk mångfald och datavetenskap |

| Mogon | Johannes Gutenberg universitet Mainz | 283,90 | 33 792 Opteron 6272 | 84 | 467 kW | Naturvetenskap, fysik, matematik, biologi, medicin |

| OCuLUS | Paderborn Center for Parallel Computing , University of Paderborn | 200,00 | 614 noder dubbla Intel E5-2670 (9856 kärnor) och 64 GB RAM | 45 | Teknik, naturvetenskap | |

| HLRE 2 | German Climate Computing Center Hamburg | 144,00 | 8064 IBM Power6 Dual Core CPU: er, 6 petabyte disk | 20: e | Klimatmodellering | |

| Komplex MPI 2 | RWTH Aachen | 103,60 | 176 noder med totalt 1 408 Intel Xeon 2,3 GHz 8-kärniga processorer | 22: a | Vetenskapliga tillämpningar | |

| HPC-FF | forskningscentrum Julich | 101,00 | 2160 Intel Core i7 (Nehalem-EP) 4-kärniga 2,93 GHz-processorer | 24 | Europeisk fusionsforskning | |

| HLRB II | LRZ Garching | 56,52 | 9728 processorer 1,6 GHz Intel Itanium 2 (Montecito Dual Core) | 39 | Naturvetenskap, astrofysik och materialforskning | |

| ClusterVision HPC | Tekniska universitetet Bergakademie Freiburg | 22.61 | 1728 kärnor Intel Xeon X5670 (2,93 GHz) + 280 kärnor AMD Opteron 6276, (2,3 GHz) | 0,5 | Teknik, kvantkemi, vätskemekanik, geofysik | |

| CHiC Cluster ( IBM x3455 ) | Chemnitz tekniska universitet | 8.21 | 2152 kärnor från 1076 dubbelkärnig 64 -bitars AMD Opteron 2218 (2,6 GHz) | Modellering och numeriska simuleringar |

Utvalda nuvarande superdatorer (DACH exklusive Tyskland)

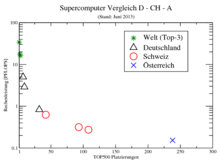

De 3 snabbaste datorerna från Schweiz och Österrike. Data från Top500 List 2017 poster Pos. 3, 82, 265, 330, 346, 385. Det finns ingen från Liechtenstein i listan över de 500 snabbaste superdatorer i världen. (Från och med juni 2017)

| Efternamn | Plats | Tera FLOPS (topp) | konfiguration | TB RAM | Energikrav | ändamål |

|---|---|---|---|---|---|---|

| Piz Daint (uppgradering 2016/2017, från juni 2017) | Swiss National Supercomputing Center (CSCS) ( Schweiz ) | 19 590,00 | Cray XC50, Xeon E5-2690v3 12C 2,6 GHz, Aries interconnect, NVIDIA Tesla P100, Cray Inc. (361760 kärnor) | 2.272 kW | ||

| Piz Daint Multicore (från juni 2017) | Swiss National Supercomputing Center (CSCS) ( Schweiz ) | 1 410,70 | Cray XC40, Xeon E5-2695v4 18C 2,1 GHz, Aries interconnect, Cray Inc. (44 928 kärnor) | 519 kW | ||

| EPFL Blue Brain IV (i juni 2017) | Swiss National Supercomputing Center (CSCS) ( Schweiz ) | 715,60 | BlueGene / Q, Power BQC 16C 1.600GHz, Custom Interconnect; IBM (65 536 kärnor) | 329 kW | ||

| VSC-3 (från juni 2017) | Vienna Scientific Cluster ( Wien , Österrike ) | 596,00 | Oljebladserver, Intel Xeon E5-2650v2 8C 2,6 GHz, Intel TrueScale Infiniband; ClusterVision (32 768 kärnor) | 450 kW | ||

| Cluster Platform DL360 (från juni 2017) | Värdbolag ( Österrike ) | 572,60 | Cluster Platform DL360, Xeon E5-2673v4 20C 2,3 GHz, 10G Ethernet; HPE (26 880 kärnor) | 529 kW | ||

| Cluster Platform DL360 (från juni 2017) | Värdbolag ( Österrike ) | 527,20 | Cluster Platform DL360, Xeon E5-2673v3 12C 2,4 GHz, 10G Ethernet; HPE (20 352 kärnor) | 678 kW |

Den snabbaste i sin tid i historien

Följande tabell (från juni 2017) listar några av deras tids snabbaste superdatorer:

| år | Superdatorer | Toppfart upp till 1959 i operationer per sekund (OPS) från 1960 i FLOPS |

plats |

|---|---|---|---|

| 1906 | Babbage Analytical Engine, Mill | 0,3 | RW Munro , Woodford Green , Essex , England |

| 1928 | IBM 301 | 1.7 | olika platser över hela världen |

| 1931 | Fliken IBM Columbia Difference | 2.5 | Columbia University |

| 1940 | Zuse Z2 | 3.0 | Berlin , Tyskland |

| 1941 | Zuse Z3 | 5.3 | Berlin , Tyskland |

| 1942 | Atanasoff-Berry Computer (ABC) | 30,0 | Iowa State University , Ames (Iowa) , USA |

| TRE Heath Robinson | 200,0 | Bletchley Park , Milton Keynes , England | |

| 1 000,0 | motsvarar 1 kilo OPS | ||

| 1943 | Blommor Colossus | 5,000,0 | Bletchley Park , Milton Keynes , England |

| 1946 |

UPenn ENIAC (före 1948+ ändringarna) |

50 000,0 | Aberdeen Proving Ground , Maryland , USA |

| 1954 | IBM NORC | 67 000,0 | US Naval Proving Ground , Dahlgren , Virginia , USA |

| 1956 | MED TX-0 | 83 000,0 | Massachusetts Inst. Of Technology , Lexington , Massachusetts , USA |

| 1958 | IBM SAGE | 400 000,0 | 25 amerikanska flygvapenbaser i USA och en plats i Kanada (52 datorer) |

| 1960 | UNIVAC LARC | 500 000,0 | Lawrence Livermore National Laboratory , Kalifornien, USA |

| 1 000 000,0 | motsvarar 1 MFLOPS, 1 Mega-FLOPS | ||

| 1961 | IBM 7030 "Stretch" | 1 200 000,0 | Los Alamos National Laboratory , New Mexico , USA |

| 1964 | CDC 6600 | 3 000 000,0 | Lawrence Livermore National Laboratory , Kalifornien, USA |

| 1969 | CDC 7600 | 36 000 000,0 | |

| 1974 | CDC STAR-100 | 100,000,000,0 | |

| 1975 | Burroughs ILLIAC IV | 150 000 000,0 | NASA Ames Research Center , Kalifornien, USA |

| 1976 | Cray-1 | 250 000 000,0 | Los Alamos National Laboratory , New Mexico, USA (över 80 sålda över hela världen) |

| 1981 | CDC Cyber 205 | 400 000 000,0 | olika platser över hela världen |

| 1983 | Cray X-MP / 4 | 941 000 000,0 | Los Alamos nationella laboratorium ; Lawrence Livermore National Laboratory ; Battelle ; Boeing |

| 1 000 000 000,0 | motsvarar 1 GFLOPS, 1 Giga-FLOPS | ||

| 1984 | M-13 | 2 400 000 000,0 | Scientific Research Institute of Computer Complex , Moskva, Sovjetunionen |

| 1985 | Cray-2 /8 | 3 900 000 000,0 | Lawrence Livermore National Laboratory , Kalifornien, USA |

| 1989 | ETA10 -G / 8 | 10 300 000 000 000,0 | Florida State University , Florida , USA |

| 1990 | NEC SX-3 / 44R | 23 200 000 000,0 | NEC Fuchu Plant, Fuchū , Japan |

| 1993 | Thinking Machines CM -5/1024 | 65 500 000 000,0 | Los Alamos nationella laboratorium ; National Security Agency |

| Fujitsu numerisk vindtunnel | 124 500 000 000,0 | National Aerospace Laboratory , Tokyo , Japan | |

| Intel Paragon XP / S 140 | 143 400 000 000,0 | Sandia National Laboratories , New Mexico, USA | |

| 1994 | Fujitsu numerisk vindtunnel | 170 400 000 000,0 | National Aerospace Laboratory , Tokyo, Japan |

| 1996 | Hitachi SR2201 / 1024 | 220 400 000 000,0 | Tokyo University , Japan |

| 1996 | Hitachi / Tsukuba CP-PACS / 2048 | 368.200.000.000.0 | Center for Computational Physics , University of Tsukuba , Tsukuba , Japan |

| 1.000.000.000.000.0 | motsvarar 1 TFLOPS, 1 Tera-FLOPS | ||

| 1997 | Intel ASCI Röd / 9152 | 1 338 000 000 000,0 | Sandia National Laboratories, New Mexico, USA |

| 1999 | Intel ASCI Röd / 9632 | 2,379,600,000,000,0 | |

| 2000 | IBM ASCI Vit | 7 226 000 000 000,0 | Lawrence Livermore National Laboratory , Kalifornien, USA |

| 2002 | NEC Earth Simulator | 35 860 000 000 000,0 | Earth Simulator Center , Yokohama- shi, Japan |

| 2004 | SGI Project Columbia | 42 700 000 000 000,0 | Projekt Columbia, NASA Advanced Supercomputing Facility , USA |

| IBM BlueGene / L | 70 720 000 000 000,0 | US Department of Energy / IBM, USA | |

| 2005 | IBM BlueGene / L | 136 800 000 000 000,0 |

US Department of Energy / US National Nuclear Security Administration , Lawrence Livermore National Laboratory , Kalifornien, USA |

| 1 000 000 000 000 000,0 | motsvarar 1 PFLOPS, 1 Peta-FLOPS | ||

| 2008 | IBM Roadrunner | 1 105 000 000 000 000,0 |

US Department of Energy / US National Nuclear Security Administration , Los Alamos National Laboratory |

| 2010 | Tianhe-1A | 2.507.000.000.000.000.0 | Nationellt superdatorcenter i Tianjin , Kina |

| 2011 | K dator | 10 510 000 000 000 000,0 | Advanced Institute for Computational Science, Japan |

| 2012 | Sequoia | 16 324 750 000 000 000,0 | Lawrence Livermore National Laboratory , Kalifornien, USA |

| 2012 | titan | 17 590 000 000 000 000 000,0 | Oak Ridge National Laboratory , Tennessee , USA |

| 2013 | Tianhe-2 | 33 863 000 000 000 000,0 | Nationellt superdatorcenter i Guangzhou , Kina |

| 2016 | Sunway TaihuLight | 93.000.000.000.000.000.0.0 | National Supercomputing Center, Wuxi , Kina |

| 2018 | Topp | 200 000 000 000 000 000,0 | Oak Ridge National Laboratory , Tennessee , USA |

| 1.000.000.000.000.000.000.0.0 | motsvarar 1 EFLOPS, 1 Exa-FLOPS | ||

| framtida | Tianhe-3 | 1.000.000.000.000.000.000.0.0 | Kina, National Center for Supercomputers - Byggstart i februari 2017, färdigställande av prototypen som tillkännagavs i början av 2018 |

| Gräns | 1 500 000 000 000 000 000 0 | USA, Oak Ridge National Laboratory (ORNL) - Slutförande meddelades 2021 | |

| El Capitan | 2.000.000.000.000.000.000.0.0 | USA, DOE: s Lawrence Livermore National Laboratory (LLNL) - färdigställande 2023 |

Om du plottar FLOP: arna för de snabbaste datorerna i sin tid mot tid får du en exponentiell kurva, logaritmisk ungefär en rak linje, som visas i följande graf.

Framtida utveckling av superdatorer

Förenta staterna

Med en verkställande order har USA: s president Barack Obama beordrat de amerikanska federala myndigheterna att gå vidare med utvecklingen av en ExaFlops -superdator . Under 2018 förväntas Intels Aurora superdator ha en datorkraft på 180 PetaFlops . DOE planerar att starta sin första exascale superdator 2021 och ta den i drift 9 månader senare.

Kina

Kina vill utveckla en superdator med en hastighet i exaflops -området till 2020. Prototypen av "Tianhe-3" ska vara klar i början av 2018, rapporterade "China Daily" den 20 februari 2017. I maj 2018 presenterades den.

Europa

Under 2011 startade många projekt i EU i syfte att utveckla programvara för exascale superdatorer. CRESTA-projektet (Collaborative Research into Exascale Systemware, Tools and Applications), DEEP-projektet (Dynamical ExaScale Entry Platform) och Mont-Blanc-projektet. Ett annat viktigt projekt är MaX (Materials at the Exascale). SERT -projektet startade i mars 2015 med deltagande av University of Manchester och STFC i Cheshire .

Se även: Europeisk högpresterande datorer .

Japan

I Japan, 2013, började RIKEN planera ett exascale -system för 2020 med en strömförbrukning på mindre än 30 MW. 2014 fick Fujitsu i uppdrag att utveckla nästa generation av K -datorn . År 2015 meddelade Fujitsu vid International Supercomputing Conference att denna superdator skulle använda processorer av ARMv8 -arkitekturen .

Andra tjänster

Milstolpar

- 1997: Deep Blue 2 (högpresterande dator från IBM) är den första datorn som slog en världsmästare i schack i en officiell duell.

- 2002: Yasumasa Kanada bestämmer cirkelnumret Pi med en Hitachi SR8000 från University of Tokyo till en noggrannhet på 1,24 biljoner siffror.

- 2007: Intels stationära processor Core 2 Quad Q6600 uppnår cirka 38,40 GFLOPS och ligger därför på superdatornivån i början av 1990 -talet.

- 2014: NVIDIA: s Tesla K80 GPU -processor uppnår en prestanda på cirka 8,7 TeraFLOPS, vilket är superdatornivån i början av 2000 -talet. Det slår därmed årets superdator 2000, IBM ASCI White, som vid den tiden erbjöd en prestanda på 7.226 TeraFLOPS.

- 2020: Xbox Series X uppnår en prestanda på 12 TFLOPS.

Jämförelser

- De mer än 500 000 aktiva datorerna i Berkeley Open Infrastructure for Network Computing (BOINC för kort) ger för närvarande (från januari 2020) en maximal datorkraft på cirka 26 PetaFLOPS, som kan variera beroende på dag.

- De mer än 380 000 aktiva datorerna i projektet Folding @ home gav en datakraft på över 1 ExaFLOP i mars 2020. Detta gör Volunteer - Distributed System till det första datasystemet som uppnår exaFLOPS. Systemet simulerade proteinvikning för forskning om COVID-19 och nådde en hastighet på cirka 2,43 x86-ExaFLOPS den 13 april-flera gånger snabbare än den tidigare rekordhållaren, Supercomputer Summit .

- Earth Simulator kunde göra alla beräkningar av alla datorer världen över från 1960 till 1970 på cirka 35 minuter.

- Om var och en av de cirka 7 miljarder människor i världen slutförde en beräkning varje sekund med en miniräknare utan avbrott, skulle hela mänskligheten behöva arbeta 538 år för att göra vad Tianhe-2 kunde göra på en timme.

- Med sin prestanda kunde K -datorn "räkna" meter av ett ljusår på ungefär en sekund.

- Hans Moravec satte hjärnans datorkraft på 100 teraflops , Raymond Kurzweil på 10 000 teraflops. Superdatorer har redan överskridit denna datorkraft avsevärt. Som jämförelse har ett grafikkort för 800 euro (11/2020) en prestanda på cirka 30 teraflops. (se teknologisk singularitet )

Korrelatorer i jämförelse

Korrelatorer är specialanordningar inom radiointerferometri vars prestanda också kan mätas i enheter av FLOP. De faller inte under kategorin superdatorer eftersom de är specialiserade datorer som inte kan lösa alla typer av problem.

- Korrelatorn Atacama Large Millimeter / submillimeter Array (ALMA) kör för närvarande (december 2012) 17 PetaFLOPS.

- Beräkningseffekten för WIDAR -korrelatorn på de expanderade mycket stora matriserna (EVLA) ges (juni 2010) som 40 PetaFLOPS.

- Den planerade korrelatorn för Square Kilometer Array (SKA) (byggtiden 2016 till 2023) bör kunna utföra 4 ExaFLOPS (4000 PetaFLOPS) (information från juni 2010).

litteratur

- Werner Gans: Supercomputing: Records; Innovation; Perspektiv . Ed.: Christoph Pöppe (= Vetenskaplig / dokumentation . Nr. 2 ). Spectrum-der-Wissenschaft-Verl.-Ges., Heidelberg 2007, ISBN 978-3-938639-52-8 .

- Shlomi Dolev: Optisk superdator . Springer, Berlin 2008, ISBN 3-540-85672-2 .

- William J. Kaufmann, et al.: Supercomputing and the transformation of science . Scientific American Lib., New York 1993, ISBN 0-7167-5038-4 .

- Paul B. Schneck: Superdatorarkitektur . Kluwer, Boston 1987, ISBN 0-89838-238-6 .

- Aad J. van der Steen: Utvärdering av superdatorer - strategier för att utnyttja, utvärdera och jämföra datorer med avancerade arkitekturer . Chapman och Hall, London 1990, ISBN 0-412-37860-4 .

webb-länkar

- TOP500 lista över mest kraftfulla superdatorer (engelska)

- TOP500 lista över de mest energieffektiva superdatorn (engelska)

- International Conference for High Performance Computing and Communications (engelska)

- The International Supercomputing Conference (engelska)

- Nyhetsbrev om superdatorer och big data (engelska och tyska)

Individuella bevis

- ↑ Mario Golling, Michael Kretzschmar: Utveckling av en arkitektur för redovisning i dynamiska virtuella organisationer . ISBN 978-3-7357-8767-5 .

- ↑ Martin Kleppmann: Designa dataintensiva applikationer: Koncept för pålitliga, skalbara och underhållbara system . O'Reilly, ISBN 978-3-96010-183-3 .

- ↑ Använda exemplet på SuperMUC : superdatorer och exportkontroll. Information om internationella vetenskapliga samarbeten. (PDF; 293 kB) BMBF , åtkomst den 14 juni 2018 .

- ↑ a b Lista statistik

- ↑ Kina försvarar toppositionen orf. Den 19 juni 2017, öppnade 19 juni 2017.

- ↑ The Green 500 List ( Memento av den ursprungliga från augusti 26, 2016 i Internet Archive ) Info: Den arkiv länk infördes automatiskt och har ännu inte kontrollerats. Kontrollera original- och arkivlänken enligt instruktionerna och ta sedan bort detta meddelande.

- ↑ Lenovos största leverantör Top500 Computer Business Wire 26.6.2018

- ↑ USA har återigen den mest kraftfulla superdatorn orf.at, 24 juni 2018, åtkomst den 24 juni 2018.

- ↑ Jack Dongarra : Reserapport till Kina och Tianhe-2 superdator, 3 juni 2013 (PDF; 8,2 MB)

- ↑ a b http://www.hlrs.de/systems/hpe-apollo-9000-hawk/

- ↑ a b https://www.uni-stuttgart.de/en/university/news/press-release/Hawk-Supercomputer-Inaugurated/

- ↑ asc.llnl.gov ASC Sequoia

- ↑ a b JUQUEEN Research Center Jülich

- ↑ superdatorer. ECMWF , 2013, öppnade 14 juni 2018 .

- ↑ a b Superdatorer: USA återfår toppositionen . Heise Online, 18 juni 2012

- ↑ SuperMUC Petascale System . lrz.de

- ↑ Tekniska data

- ↑ sysGen -projektreferens (PDF; 291 kB) Bielefeld -universitetet, Fysiska fakulteten

- ↑ SMYCKER - Konfiguration. Forschungszentrum Jülich , åtkomst den 28 juni 2018 .

- ↑ LRZ: SuperMUC nr 4 på Top500 -listan

- ^ HLRN

- ↑ Andreas Stiller: Superdator vid TU Dresden går officiellt i drift. I: Heise online . 13 mars 2015, åtkomst 14 juni 2018 .

- ↑ Andreas Stiller: Ny petaflops -dator vid TU Dresden. I: c't . 29 maj 2015, åtkomst 14 juni 2018 .

- ↑ HLRE-3 "Mistral". DKRZ , åtkomst den 14 juni 2018 .

- ↑ a b Datorhistorik vid DKRZ. DKRZ , åtkomst den 14 juni 2018 .

- ↑ Lichtenberg högpresterande dator. HHLR, åtkomst den 4 augusti 2016 .

- ↑ HPC -system vid University of Oldenburg

- ↑ Oldenburg universitetsdatorer är bland de snabbaste i världen

- ↑ OCuLUS

- ↑ ClusterVision HPC ( Memento från 23 februari 2015 i Internetarkivet )

- ↑ Chic ( Memento av den ursprungliga daterad 9 feb 2007 i Internet Archive ) Info: Den arkiv länk infördes automatiskt och har ännu inte kontrollerats. Kontrollera original- och arkivlänken enligt instruktionerna och ta sedan bort detta meddelande.

- ↑ IBM 301 Accounting Machine

- ^ Tabulatoren Columbia Difference - 1931

- ↑ Andreas Stiller: Superdator: Kina övertar USA. I: Heise online . 20 juni 2016. Hämtad 14 juni 2018 .

- ↑ ORNL lanserar Summit -superdator. Oak Ridge National Laboratory , 8 juni 2018, öppnade 14 juni 2018 .

- ↑ a b Kina började bygga en ny superdator orf. Den 20 februari 2017, öppnade den 20 februari 2017.

- ↑ Marc Sauter: Frontier med 1,5 exaflops: AMD bygger världens snabbaste superdatorer. I: golem.de. 7 maj 2019, öppnade 16 juli 2019 .

- ↑ HPE och AMD driver komplex vetenskaplig upptäckt i världens snabbaste superdator för US Department of Energy's (DOE) National Nuclear Security Administration (NNSA). 4 mars 2020, åtkomst 6 mars 2020 .

- ↑ Vita huset: SKAPA EN NATIONELL STRATEGISK DATOR Åtkomst januari 2017

- ↑ golem.de: Hur Exaflop -märket ska sprickas Åtkomst : januari 2017

- ↑ Aurora superdator . top500.org. 2016. Hämtad 13 januari 2017.

- ^ Första amerikanska Exascale -superdator nu på spår för 2021 . top500.org. 10 december 2016. Hämtad 13 januari 2017.

- ↑ China Research: Exascale Supercomputer. Hämtad januari 2017

- ↑ http://german.xinhuanet.com/2018-05/18/c_137187901.htm

- ^ Europe Gears Up för Exascale Software Challenge med 8,3 miljoner Euro CRESTA -projektet . Projektkonsortium. 14 november 2011. Hämtad 10 december 2011.

- ↑ Booster för nästa generations superdatorer Kick-off för det europeiska exascale-projektet DEEP . FZ Jülich. 15 november 2011. Hämtad 13 januari 2017.

- ↑ Superdator med turboladdare . FZ Jülich. 5 november 2016. Hämtad 13 januari 2017.

- ↑ Mont-Blanc-projektet sätter upp Exascales mål . Projektkonsortium. 31 oktober 2011. Hämtad 10 december 2011.

- ↑ MaX webbplats . projektkonsortium. 25 november 2016. Hämtad 25 november 2016.

- ^ Utveckla simuleringsprogramvara för att bekämpa mänsklighetens största problem . Vetenskaplig beräkning. 25 februari 2015. Hämtad 8 april 2015.

- ^ Patrick Thibodeau: Varför USA kan förlora loppet om exascale . I: Computerworld . 22 november 2013.

- ↑ RIKEN väljer entreprenör för grundläggande utformningen av post-K superdator . I: www.aics.riken.jp . 1 oktober 2014.

- ↑ Fujitsu väljer 64-bitars ARM för Japans monster 1000-PFLOPS super . I: www.theregister.co.uk . 20 juni 2016.

- ↑ intel.com

- ^ Michael Günsch: Tesla K80: Dual Kepler med upp till 8,7 TFLOPS för superdatorer. I: ComputerBase . 17 november 2014, åtkomst 14 juni 2018 .

- ↑ XBOX -SERIEN X. I: Microsoft . 2021, öppnade 16 maj 2021 .

- ↑ Host översikt på boincstats.com

- ↑ Översikt över BOINC -tjänster på boincstats.com

- ↑ Rapport om vikande @ hemstatistik. Hämtad 26 mars 2020 (engelska).

- ↑ Folding @ home: Tack vare vårt AMAZING community har vi korsat exaFLOP -barriären! Det är över 1 000 000 000 000 000 000 operationer per sekund, vilket gör oss ~ 10 gånger snabbare än IBM Summit! Pic.twitter.com/mPMnb4xdH3. I: @foldingathome. 25 mars 2020, öppnad 26 mars 2020 .

- ↑ Folding @ Home Crushes exascale Barrier, nu snabbare än dussintals superdatorer - ExtremeTech . I: www.extremetech.com . Hämtad 13 maj 2020.

- ^ Folding @ home crowdsourced -dataprojekt klarar 1 miljon nedladdningar mitt i coronavirusforskning . I: VentureBeat , 31 mars 2020. Hämtad 13 maj 2020.

- ↑ Corona-pandemin gjorde Folding @ Home till en exaFLOP-superdator (en-us) . I: Ars Technica , 14 april 2020. Hämtad 13 maj 2020.

- ↑ CERN kastar 10 000 CPU -kärnor till Folding @ home coronavirus -simuleringsprojekt (en) . I: ZDNet . Hämtad 13 maj 2020.

- ↑ Tillräcklig kraft för 4K -spel. Hämtad 6 november 2020 .

- ↑ Kraftfull superdator gör ALMA till ett teleskop

- ↑ Den högsta superdatorn i världen jämför astronomidata . Heise online

- ↑ a b Cross -Correlators & New Correlators - Implementering och val av arkitektur . (PDF; 9,4 MB) National Radio Astronomy Observatory, s.27

- ^ The Expanded Very Large Array Project - "WIDAR" -korrelatorn . (PDF; 13,2 MB) National Radio Astronomy Observatory, s.10